解决方案与应用

全方位人工智能解决方案

人工智能应用无处不在,并且已经取得了长足的进步。大量精美、令人眼花缭乱的产品和应用正在改变世界。无论是在医疗保健、金融科技还是零售领域,你都可以看到人工智能在这些行业中发挥着重要作用。另一方面,带有人工智能标签的产品正在影响世界; AI手机、AI电脑、AI钉钉、兔子等等,它们都是由AI引擎驱动的。

如何释放这些AI产品的力量?秘密是LLM(大型语言模型)和LAM(大型动作模型)。如果没有LLM和LAM,人工智能产品就无法向最终用户传递人工智能的魔力。这些模型使用强大的人工智能服务器进行训练,这些服务器通常位于人工智能数据中心。

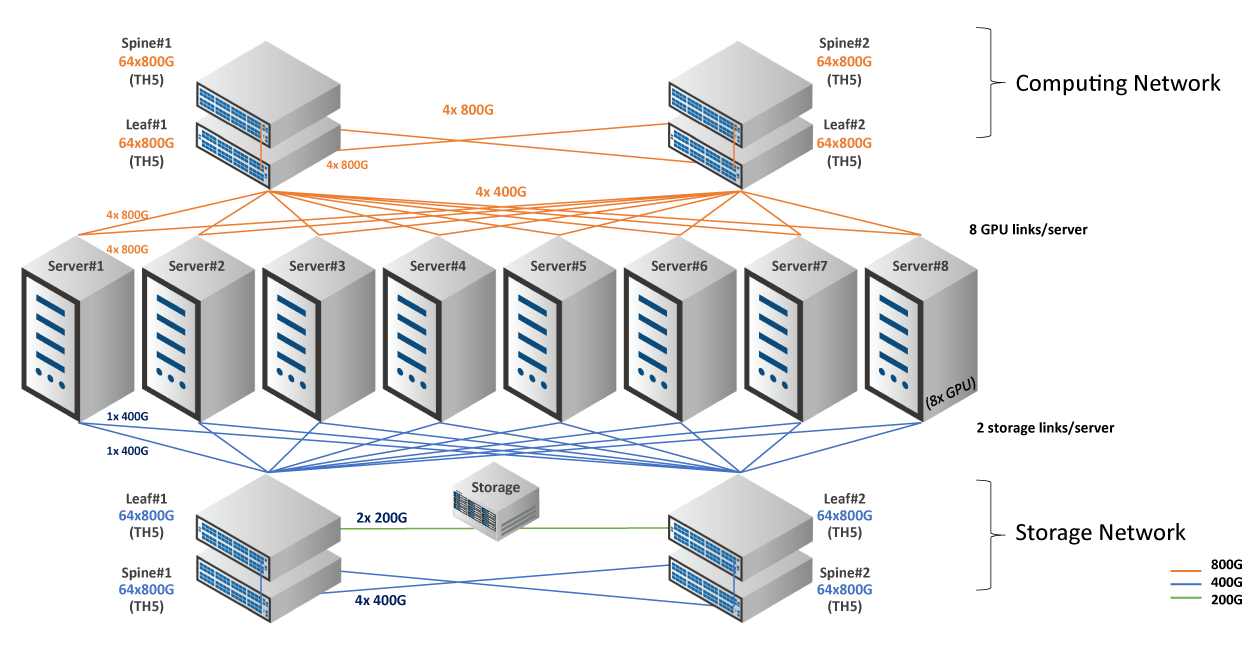

AI数据中心由AI服务器、大容量交换机、光模块、线缆组成,缺一不可。

人工智能流量具有以下特点。

从传统网络到基于人工智能的网络的转变是一种改变网络工作方式的演变。在 AI/ML 集群中,作业完成时间 (JCT) 是最重要的指标。

如何缩短工作完成时间

在 AI 网络方面,RoCE(RDMA over Converged Ethernet)扮演着重要的角色。由于 AI 网络中的无损功能非常重要,因此 RoCE 可以控制传输速率和流量拥塞。

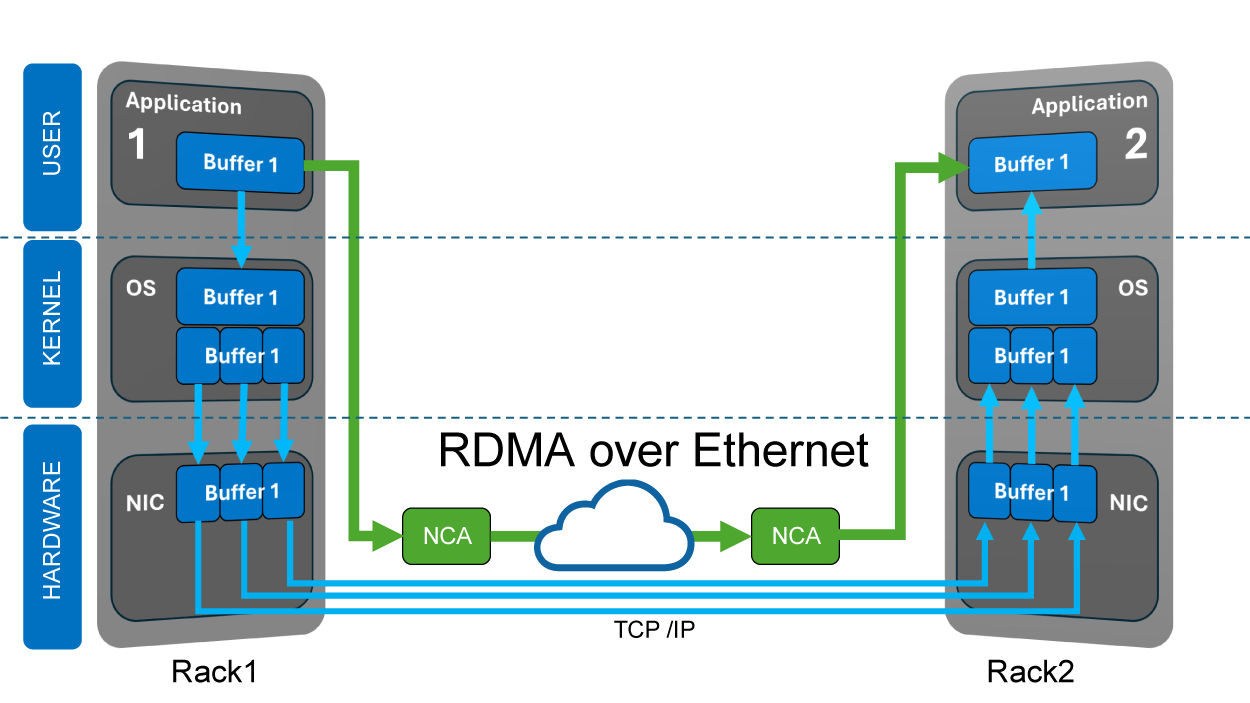

什么是 RDMA(远程直接内存访问)?RDMA 是一种能够在内存和外围设备之间或从内存到内存传输数据的技术,无需涉及 CPU 或 OS 资源。当通过以太网实现 RDMA 时,这意味着发送方直接从应用程序访问 NIC 卡内存,而 NIC 驱动程序使用 UDP 堆栈的缓冲区来减少处理开销,从而降低延迟并实现更高的吞吐量。

网络中的PFC(Priority-based Flow Control,基于优先级的流量控制)和ECN(Explicit Congestion Notification,显式拥塞通知)实现了无损传输和拥塞避免。PFC和ECN的结合就是DCQCN(Data Center Quantized Congestion Notification,数据中心量化拥塞通知),这是AI Networks的高性能拥塞管理解决方案。DCQCN是RoCEv2网络中应用最广泛的拥塞控制算法。

GPU(图形处理单元)最初是为了加速计算机图形学和图像像素的处理而设计的。如今,科学家发现 GPU 在数据科学和图像分析方面表现出色,其应用范围也更加广泛,包括 AI 和 ML(机器学习),这也是 GPU 现在被称为 GPGPU(通用图形处理单元)的原因。当 GPU 与 CPU 协同工作时,它们可以加速工作流程并释放 AI 的力量。

为何选择 Edgecore AI 解决方案

一个设计良好的AI数据中心应该考虑GPU架构、GPU特性、总成本和功耗。 Edgecore AI 解决方案针对高性能和效率进行了优化,在重负载环境中表现出色。

Edgecore 尖端 AI/ML 交换机和服务器由世界顶级芯片组供应商提供支持,并由我们经验丰富的工程师设计,可最大程度地提高计算效率。此外,Edgecore 还提供即插即用的收发器和电缆,通过可靠的验证完全符合 Edgecore 交换机的要求。您无需担心兼容性。

同时,我们采用开放式架构,积极参与不同的项目,然后为您的 AI/ML 连接需求提供完整、灵活且面向未来的解决方案。

Edgecore始终跑在市场的前面。从边缘到核心,从交换机到服务器,现在Edgecore为客户提供构建人工智能数据中心所需的一切,特别适合深度学习、训练和推理。

相关产品

▌800G QSFP112-DD-2xDR4 500m ▌SMF ▌波长(nm): 1310 ▌覆盖范围: 500m

▌800G QSFP112-DD 2xFR4 2km ▌SMF ▌波长(nm): 1310 ▌覆盖范围: 2km

▌800G OSFP SR8 50m ▌OM4 ▌波长(nm): 850 ▌覆盖范围: 50m

▌800G OSFP 2xSR4 50m ▌OM4 ▌波长(nm): 850 ▌覆盖范围: 50m

▌800G OSFP-2xFR4 2km ▌SMF ▌波长(nm): 1310 CWDM ▌覆盖范围: 2km

▌800G OSFP-2xDR4 500m ▌SMF ▌波长(nm): 1310 ▌覆盖范围: 500m