Soluções e Aplicações

Solução Total de IA

As aplicações de IA estão por toda parte e já fizeram avanços significativos. Diversos produtos e aplicações sofisticados e deslumbrantes estão mudando o mundo. Seja na área da saúde, fintech ou varejo, a IA desempenha um papel importante nesses setores. Por outro lado, produtos rotulados como IA estão impactando o mundo: celulares com IA, PCs com IA, pins com IA, Rabbit R1, etc., todos são impulsionados por mecanismos de IA.

Como liberar o poder desses produtos de IA? Os segredos são o LLM (Large Language Model) e o LAM (Large Action Model). Sem o LLM e o LAM, os produtos de IA não conseguem entregar a mágica da IA aos usuários finais. Esses modelos são treinados usando servidores de IA poderosos, normalmente localizados em data centers de IA.

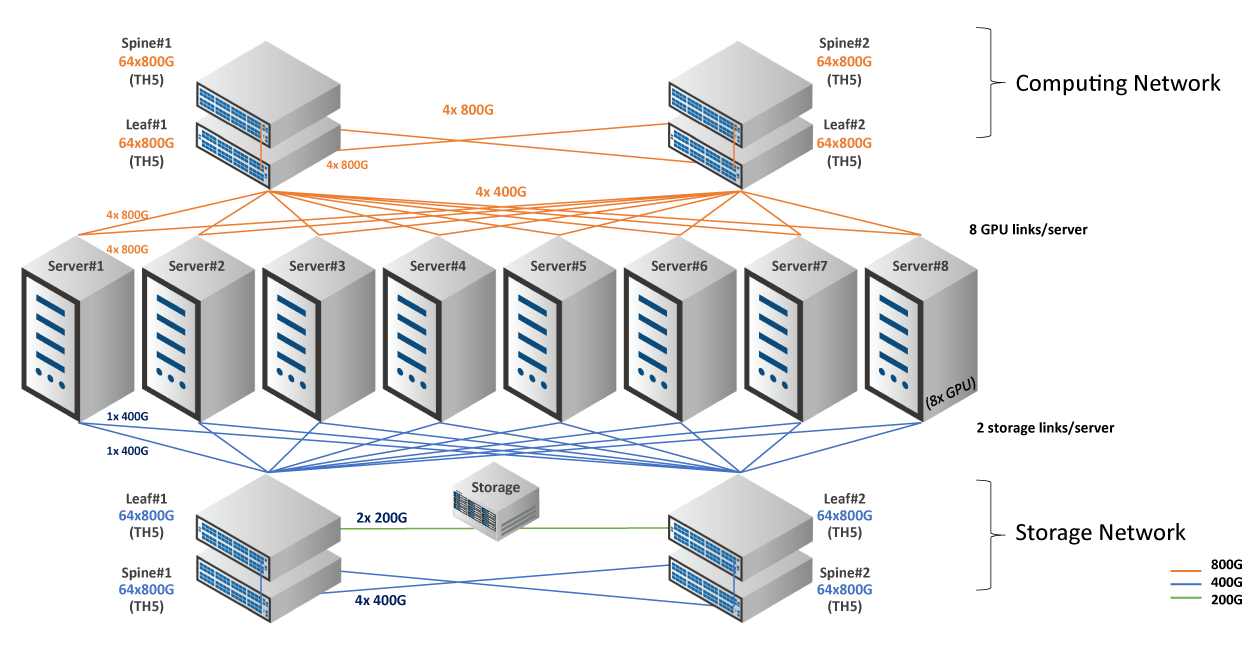

Um data center de IA é composto de servidores de IA, switches de alta capacidade, transceptores e cabos, nenhum dos quais é dispensável.

O tráfego de IA tem as seguintes características.

A transição de uma rede tradicional para uma rede baseada em IA representa uma evolução que muda a forma como a rede funciona. Em clusters de IA/ML, o tempo de conclusão da tarefa (JCT) é a métrica mais importante.

Como melhorar o tempo de conclusão do trabalho

O RoCE (RDMA sobre Ethernet Convergente) desempenha um papel importante quando falamos de redes de IA. Como a função sem perdas em redes de IA é importante, o RoCE controla a taxa de transmissão e o congestionamento do tráfego.

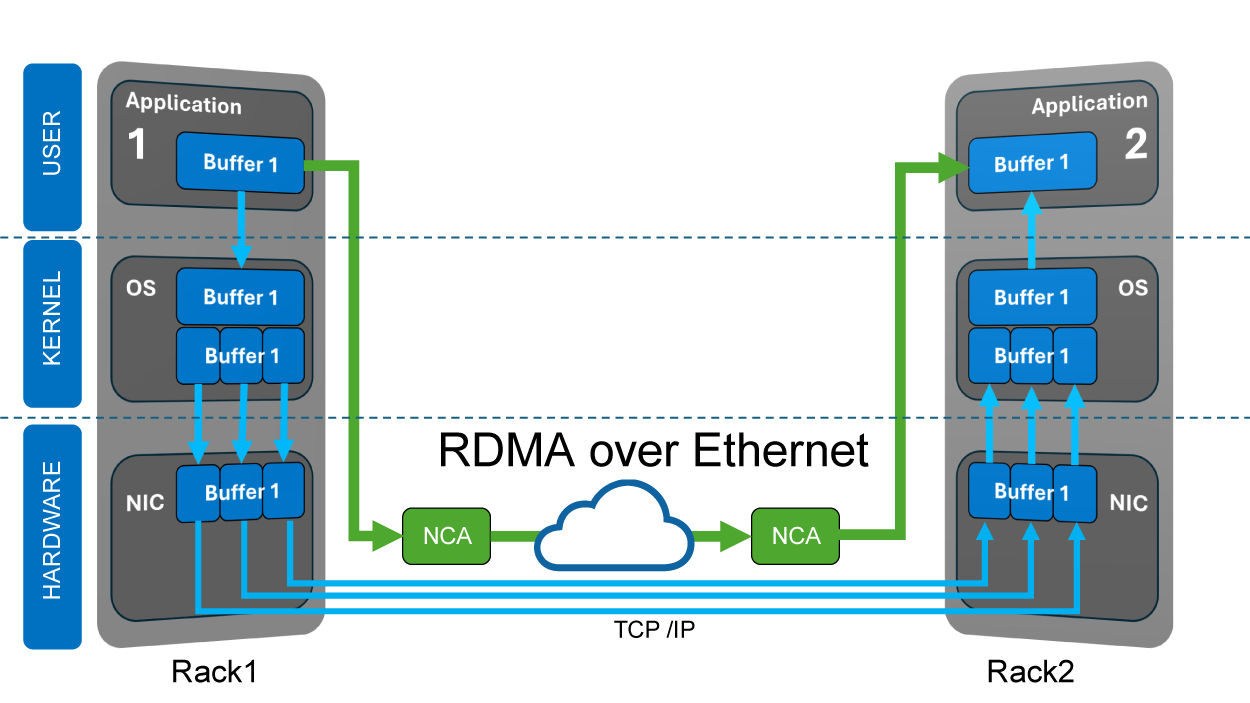

O que é RDMA (Remote Direct Memory Access)? RDMA é uma tecnologia que permite a transferência de dados entre a memória e dispositivos periféricos ou de uma memória para outra, sem envolver recursos da CPU ou do sistema operacional. Quando o RDMA sobre Ethernet é implementado, o remetente acessa diretamente a memória da placa de rede a partir do aplicativo, e o driver da placa de rede usa o buffer da pilha UDP para reduzir a sobrecarga de processamento, reduzindo a latência e alcançando maior rendimento.

O PFC (Controle de Fluxo Baseado em Prioridade) e o ECN (Notificação Explícita de Congestionamento) na rede proporcionam transmissão sem perdas e evitam congestionamentos. A combinação de PFC e ECN resulta no DCQCN (Notificação Quantizada de Congestionamento para Data Center), uma solução de gerenciamento de congestionamento de alto desempenho para redes de IA. O DCQCN é o algoritmo de controle de congestionamento mais utilizado em redes RoCEv2.

As GPUs (Unidades de Processamento Gráfico) foram inicialmente projetadas para acelerar a computação gráfica e o processamento de pixels para imagens. Hoje em dia, cientistas descobriram que as GPUs se destacam em ciência de dados e análise de imagens, além de serem aplicadas em uma gama mais ampla, incluindo IA e ML (Aprendizado de Máquina). É por isso que a GPU agora é chamada de GPGPU (Unidade de Processamento Gráfico de Computação de Propósito Geral). Quando as GPUs trabalham em conjunto com as CPUs, elas podem acelerar o fluxo de trabalho e liberar o poder da IA.

O Edgecore oferece um NOS de switch pronto para IA, o SONiC, que é suportado por um amplo espectro de plataformas de comutação, fornecendo uma Interface de Abstração de Switch (SAI) que varia de 1G a 800G, abrangendo leaf até switches de camada super-spine.

Com os versáteis switches SONiC e Edgecore, eles oferecem suporte a monitoramento e gerenciamento de telemetria, throughput otimizado por meio de redes sem perdas ajustadas e balanceamento de carga. Todos esses recursos foram projetados para reduzir o congestionamento, localizar pontos de congestionamento com precisão, otimizar a distribuição de carga e o JCT.

Além disso, a Edgecore fornece serviços e suporte completos para o SONiC em diferentes estágios, incluindo serviços de pré-venda e pós-venda.

Principais benefícios da solução

Por que soluções de IA Edgecore

Um data center de IA bem projetado deve considerar a arquitetura da GPU, os recursos da GPU, o custo total e o consumo de energia. As soluções de IA Edgecore são otimizadas para alto desempenho e eficiência, destacando-se em ambientes de carga pesada.

Os switches e servidores de IA/ML de ponta Edgecore são equipados com chipsets de fornecedores líderes mundiais e projetados por nossos engenheiros experientes, que maximizam a eficiência computacional. Além disso, a Edgecore oferece transceptores e cabos plug-and-play, totalmente qualificados com switches Edgecore por meio de validação rigorosa. Você não precisa se preocupar com compatibilidade.

Enquanto isso, adotamos a arquitetura aberta, envolvemos proativamente diferentes projetos e, em seguida, entregamos soluções completas, flexíveis e prontas para o futuro para suas necessidades de conectividade de IA/ML.

A Edgecore está sempre à frente do mercado. Da borda ao núcleo, do switch ao servidor, agora a Edgecore oferece aos clientes o que eles precisam para construir um data center de IA, especialmente adequado para aprendizado profundo, treinamento e inferência.

Acelere sua rede de IA agora!

Produtos relacionados

O Edgecore AGS8600 é um servidor de alto desempenho, escalável e baseado em GPU, adequado para aplicações de IA/ML e HPC. O servidor é ideal para treinar grandes modelos de linguagem, automação, classificação de objetos e casos de uso de reconhecimento. Projetado com oito processadores AMD Instinct MI325X e dois processadores AMD EPYC série 9005/Turin.

O Edgecore AGS8600 é um servidor de alto desempenho, escalável e baseado em GPU, adequado para aplicações de IA/ML e HPC. O servidor é ideal para treinar grandes modelos de linguagem, automação, classificação de objetos e casos de uso de reconhecimento. Projetado com oito processadores AMD Instinct MI325X e dois processadores AMD EPYC série 9005/Turin.

APS800-16O 16 portas OSFP800 de 800G, cada uma pode ser dividida em 2x400G, 4x200G ou 8x100G O SerDes suporta operação em taxas de 10G, 25G, 50G e 100G

32 x 800G OSFP800 com Tomahawk 5

Switch de alto desempenho e baixa latência para data centers de alto desempenho Orçamento de energia de até 30 W por porta

32 x 800G QSFP-DD800 com Tomahawk 5

Switch de alto desempenho e baixa latência para data centers de alto desempenho Orçamento de energia de até 30 W por porta

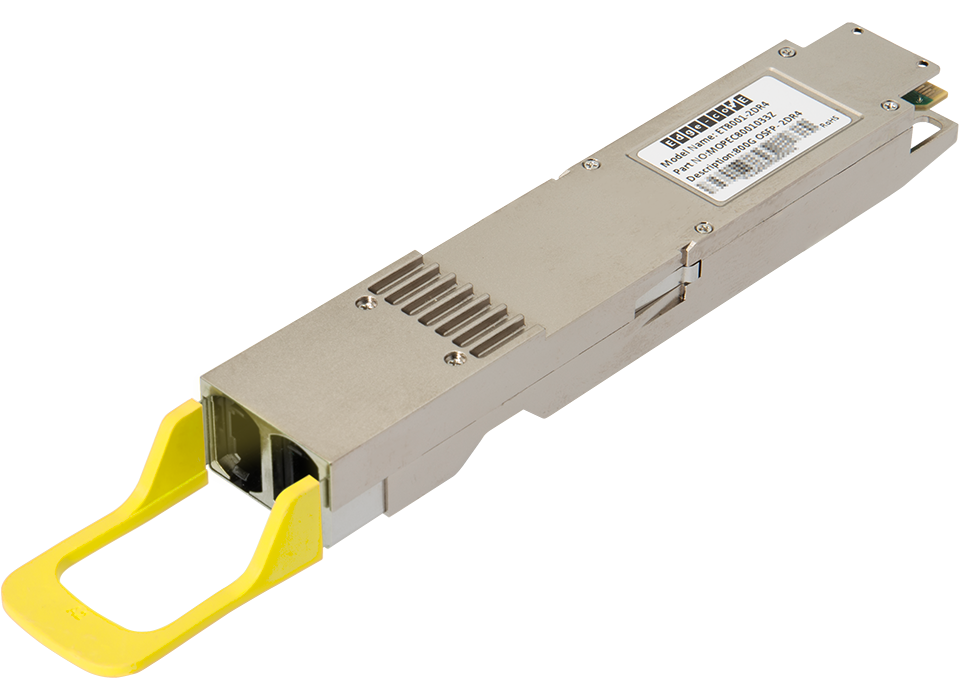

▌800G QSFP112-DD-2xDR4 500m ▌SMF ▌Comprimento de onda (nm): 1310 ▌Alcance: 500m

▌800G QSFP112-DD 2xFR4 2km ▌SMF ▌Comprimento de onda (nm): 1310 ▌Alcance: 2km

▌800G OSFP SR8 50m ▌OM4 ▌Comprimento de onda (nm): 850 ▌Alcance: 50m

▌800G OSFP 2xSR4 50m ▌OM4 ▌Comprimento de onda (nm): 850 ▌Alcance: 50m

▌800G OSFP-2xFR4 2km ▌SMF ▌Comprimento de onda (nm): 1310 CWDM ▌Alcance: 2km

▌800G OSFP-2xDR4 500m ▌SMF ▌Comprimento de onda (nm): 1310 ▌Alcance: 500m