ネクスベック™

ネクスベック™

エンタープライズAI向けターンキーオープンインフラストラクチャソリューション

コンポーザブルコンピューティング

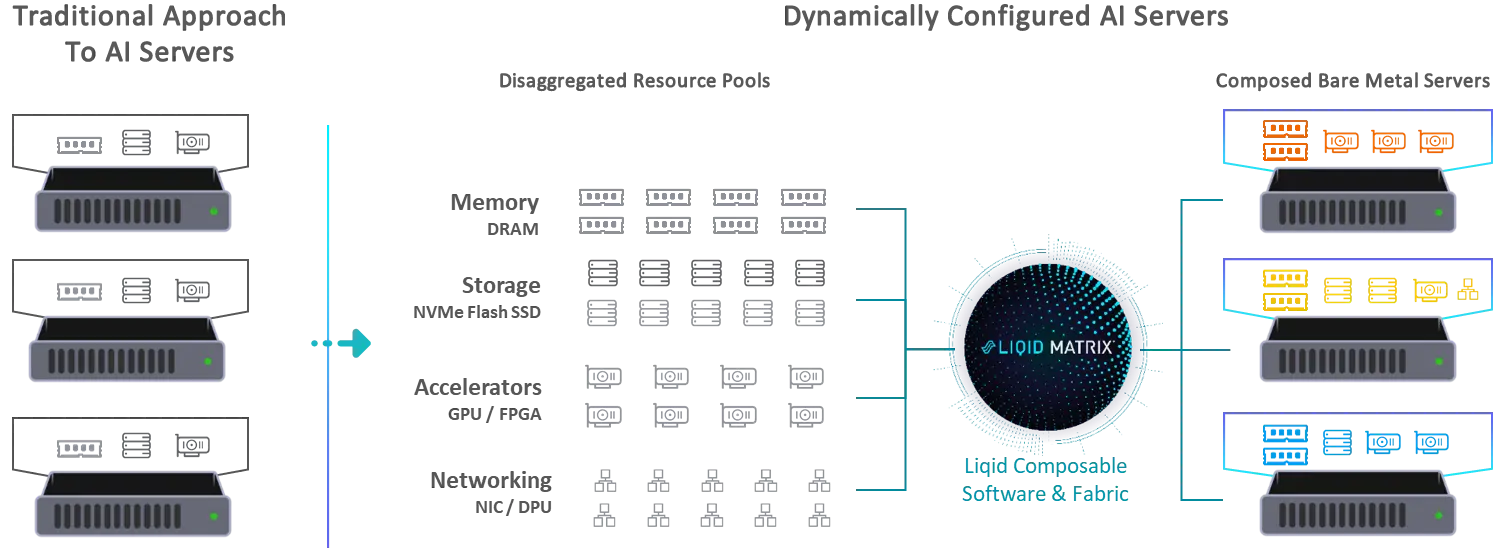

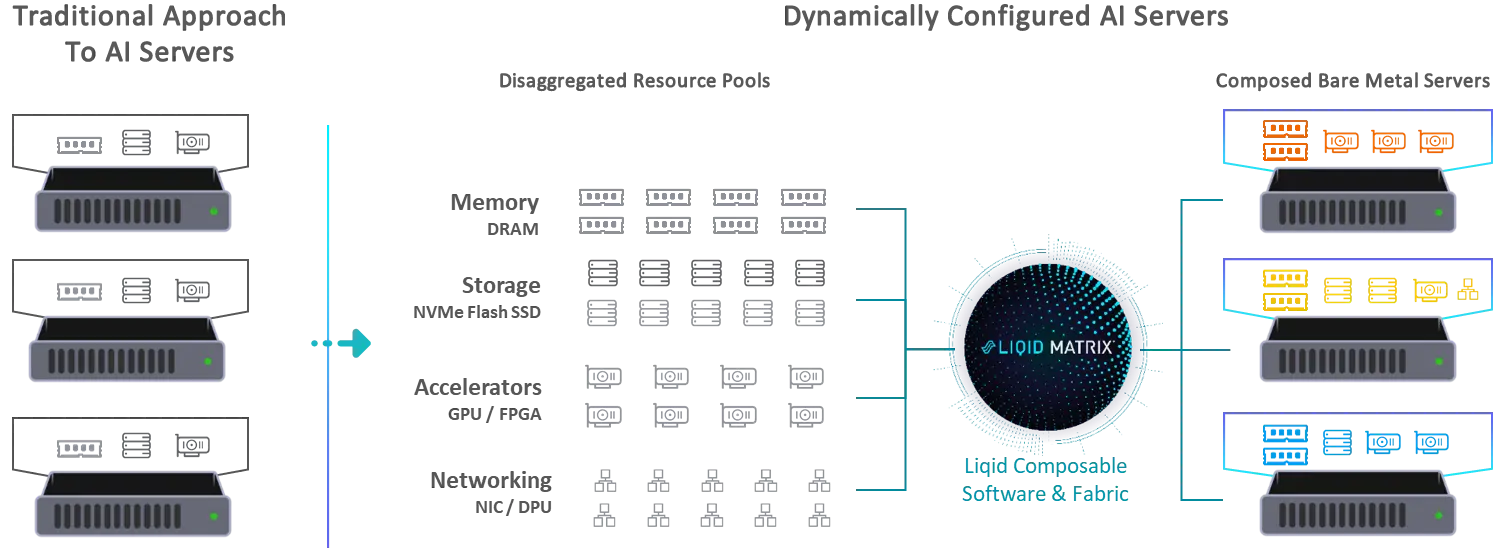

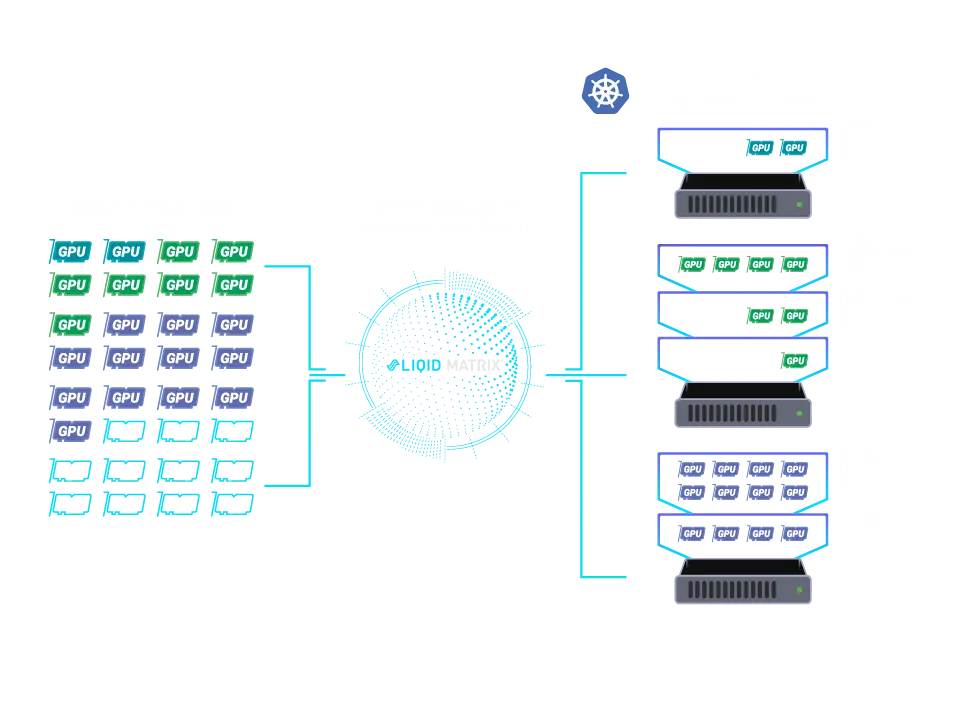

Edgecore のコンポーザブル インフラストラクチャ ソリューションは、Liqid との提携により、業界標準のデータ センター コンポーネントを利用して、分散リソースのプールから構築された柔軟でスケーラブルなアーキテクチャを作成します。

関連リソース

エンタープライズAI向けターンキーオープンインフラストラクチャソリューション

コンポーザブルコンピューティング

Edgecore のコンポーザブル インフラストラクチャ ソリューションは、Liqid との提携により、業界標準のデータ センター コンポーネントを利用して、分散リソースのプールから構築された柔軟でスケーラブルなアーキテクチャを作成します。

オンデマンドの動的リソース割り当て

コンピューティング、ネットワーク、ストレージ、GPU、FPGA、そしてIntel® Optane™メモリーは、インテリジェントなファブリックを介して相互接続され、動的に構成可能なベアメタルサーバーを実現します。各サーバーは、アプリケーションに必要な物理リソースのみを使用して、正確にカスタマイズされており、過不足はありません。

効率を向上し、無駄を削減

必要に応じてハードウェアを分解して再割り当てすることで、 リソース利用率が2倍、あるいは3倍に消費電力を大幅に削減し、二酸化炭素排出量を削減します。これは、AI 中心の展開に特に役立ちます。

リキッドマトリックステクノロジー搭載

Edgecoreのコンポーザブルインフラストラクチャは、 液体マトリックスは、インフラストラクチャがワークロードの需要にリアルタイムで適応することを可能にします。これにより、スケーラビリティと応答性を向上させながら、最大限の利用率を実現できます。

次世代ワークロードの自動化

インフラストラクチャのプロセスは完全に自動化され、次世代アプリケーションのデータ需要を満たすための新たな効率性が実現します。AI、IoT、DevOps、クラウド、エッジコンピューティング、およびサポート NVMeオーバーファブリック(NVMe-oF) そして GPU オーバーファブリック (GPU-oF) テクノロジー。

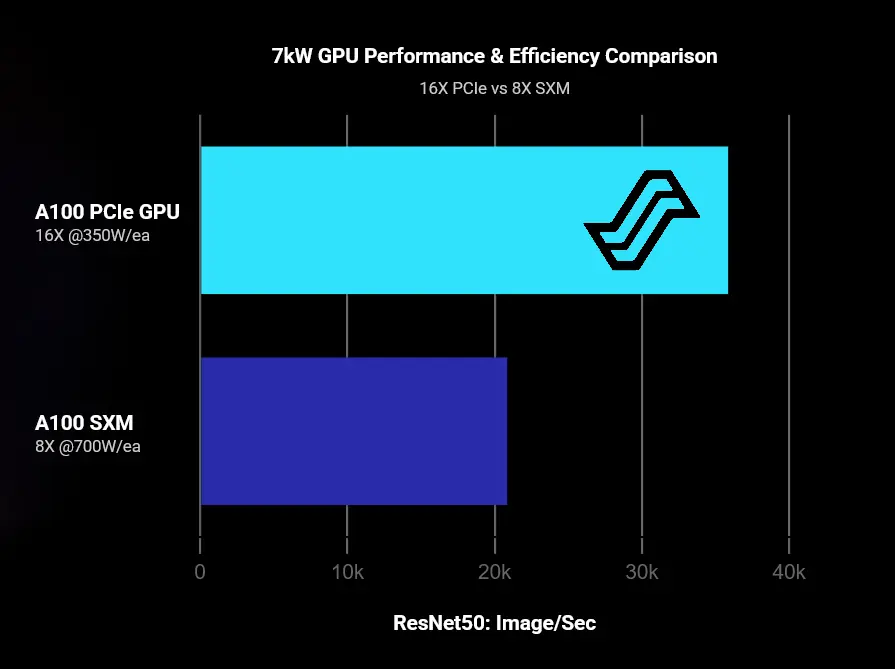

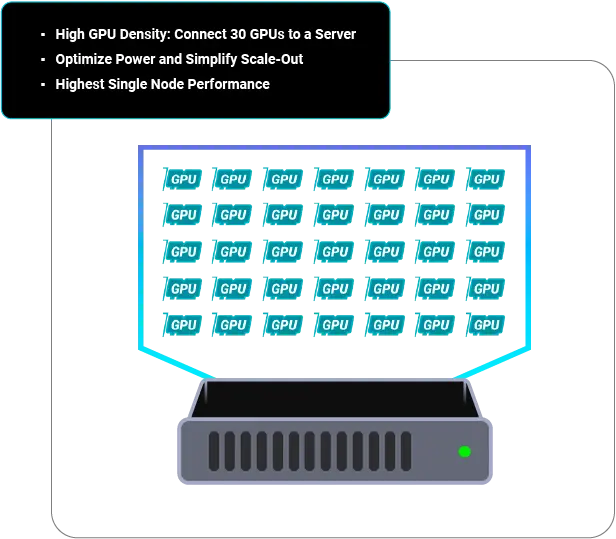

最高のAIパフォーマンス

最適化された効率

最大限の柔軟性

消費電力の低減

サーバーあたり最大30個のGPUを拡張して、AIワークロードの需要を満たしながら、消費電力を抑え、AIの利用率を高めます。

あなたのAI、あなたの選択。シリコンの多様性の力を活用して比類のない柔軟性と俊敏性を実現

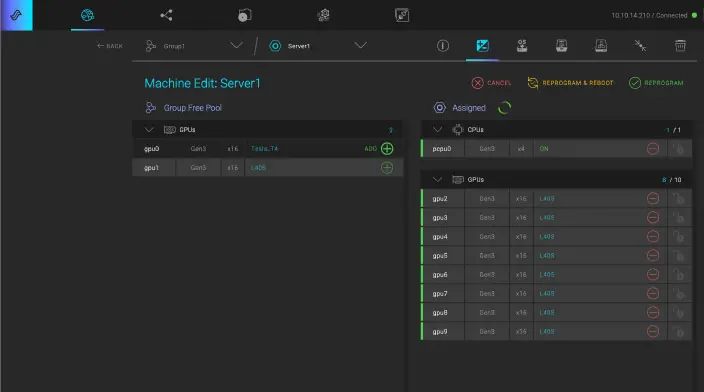

LIQID Matrix® ソフトウェア、Kubernetes、Nvidia NIM 自動化を使用して、独自のプライベート AI 推論クラウドを構築します。

独自のインフラストラクチャ アドベンチャーを選択してください。Kubernetes、VMware、SLURM 向けの直感的な UI、CLI、Northbound API を活用します。

関連リソース

私たちと一緒にビジネスを変革しましょう。

30077 新竹、台湾、新竹サイエンスパーク、研新三路 1 號

電話番号: +886-3-5638888

著作権 © 2026 Edgecoreネットワークスコーポレーション