Sua rede é o gargalo do seu cluster de IA/ML?

À medida que os data centers escalam rapidamente para acomodar redes neurais distribuídas, as arquiteturas de rede tradicionais muitas vezes não conseguem atender às exigências rigorosas de "fluxos gigantescos" e computação paralela. A diferença entre um treinamento interrompido e uma implantação bem-sucedida geralmente reside na eficiência do protocolo de transporte.

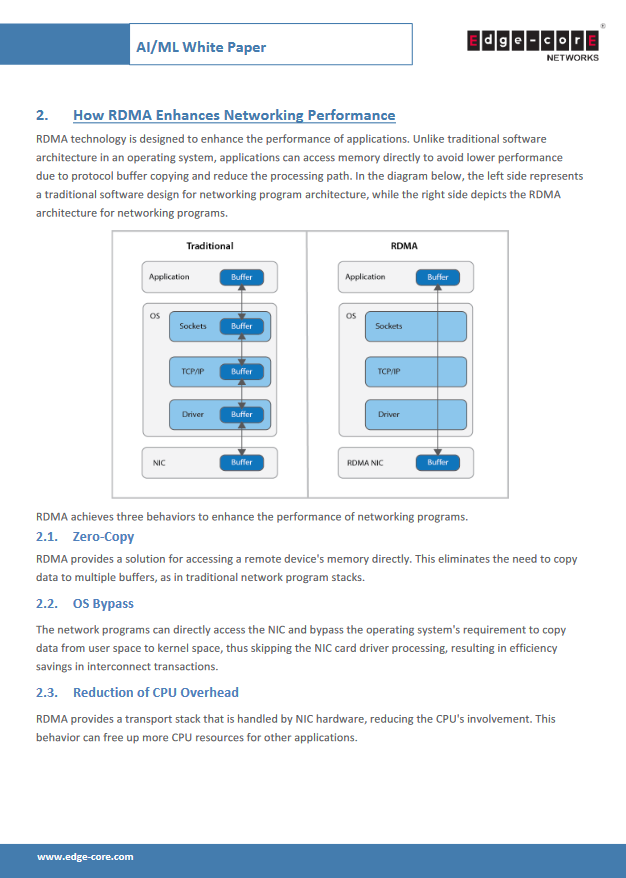

Este documento técnico, ""Contexto de redes de IA/ML,"" Este documento fornece um guia completo para otimizar ambientes de computação de alto desempenho usando RDMA sobre Ethernet Convergida (RoCEv2). Ao contrário das pilhas TCP/IP tradicionais que sobrecarregam a CPU com cópias excessivas de buffer, a tecnologia RDMA aproveita os recursos de "Cópia Zero" e "Desvio do Sistema Operacional" para permitir o acesso direto à memória, reduzindo significativamente a latência e a sobrecarga da CPU.

Lá dentro, você descobrirá:

- A vantagem do RoCEv2Por que o RoCEv2 oferece uma alternativa mais escalável e econômica ao InfiniBand sem sacrificar a capacidade de roteamento ou o desempenho?.

- Obtendo Ethernet sem perdasUma análise detalhada da configuração do Controle de Fluxo Prioritário (PFC) para evitar a perda de pacotes durante rajadas.

- Gestão de congestionamentoComo implementar a Notificação Explícita de Congestionamento (ECN) juntamente com o PFC para limitar dinamicamente as velocidades de transmissão antes que ocorram gargalos.

Baixe o relatório completo para aprender como otimizar sua rede para o alto rendimento e a baixa latência exigidos pelas cargas de trabalho de IA modernas.